Databricks Delta Live Tables

O Databricks Delta Live Tables simplifica o processo ETL com automação e qualidade de dados.

Informações básicas

O Databricks Delta Live Tables (DLT) é um framework ETL (Extração, Transformação e Carga) declarativo projetado para simplificar a criação e o gerenciamento de pipelines de processamento de dados na plataforma Databricks Lakehouse. Ele automatiza a orquestração de tarefas, o gerenciamento de clusters, o monitoramento, a aplicação de padrões de qualidade de dados e o tratamento de erros. O DLT permite que os usuários definam transformações de dados usando SQL ou Python, e a plataforma gerencia a infraestrutura e a execução subjacentes.

- Modelo: Serviço gerenciado dentro da plataforma Databricks Lakehouse.

- Versão: O DLT opera como um serviço em constante evolução, com atualizações vinculadas às versões do Databricks Runtime e lançamentos regulares de recursos. Por exemplo, os lançamentos recentes incluem as versões 2024.40 e 2024.42 do DLT.

- Data de lançamento: O Delta Live Tables foi anunciado para disponibilidade geral em 5 de abril de 2022, na AWS, Azure e Google Cloud.

- Requisitos mínimos: Requer acesso a um espaço de trabalho do Databricks com o recurso Delta Live Tables ativado, o que geralmente exige um plano Premium ou superior.

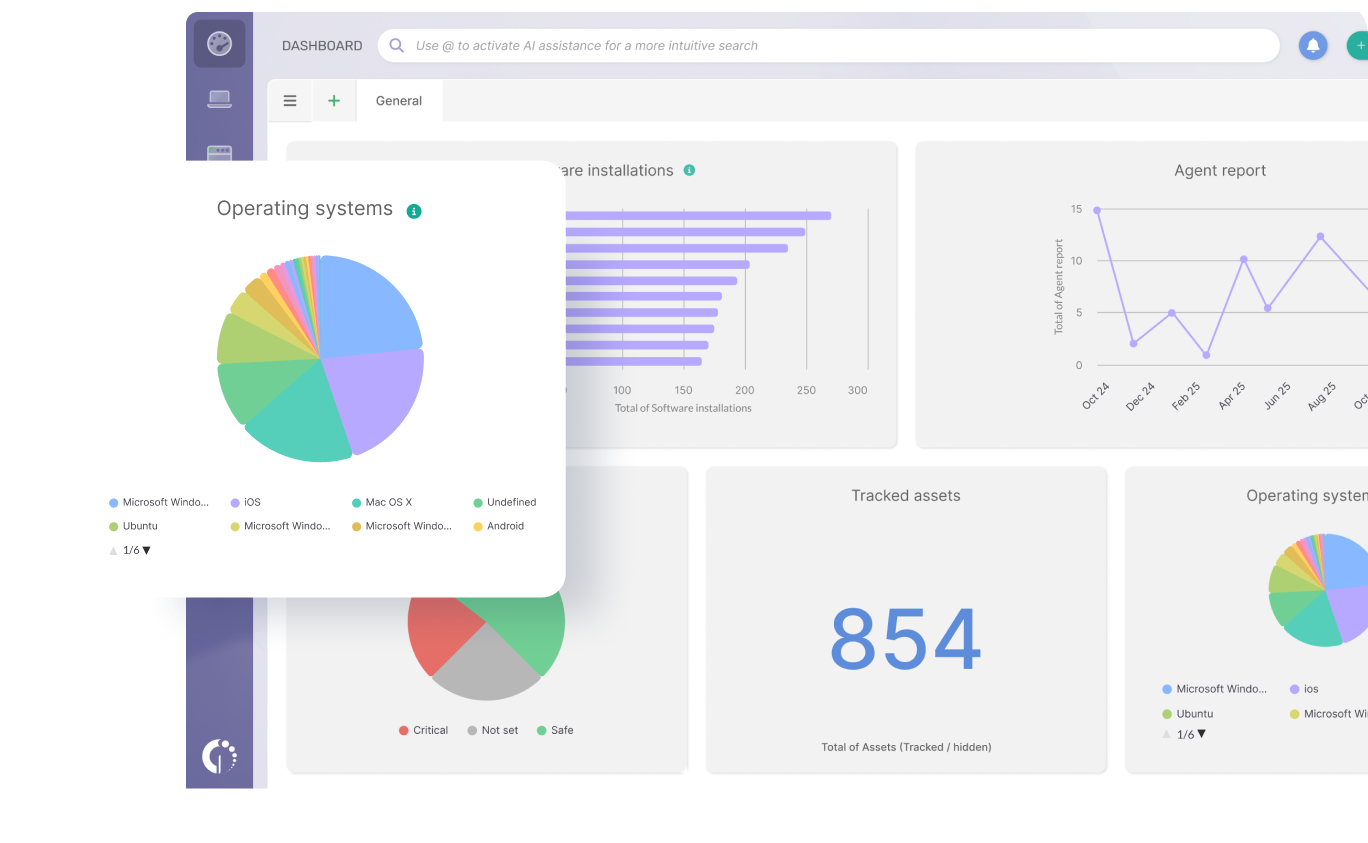

- Sistemas Operacionais Compatíveis: Como um serviço gerenciado, o DLT é executado na plataforma Databricks, que utiliza sistemas operacionais otimizados como o Photon OS ou o Ubuntu para seus clusters. Os usuários interagem com o DLT por meio de navegadores da web ou APIs do Databricks, tornando o sistema operacional do cliente praticamente irrelevante.

- Última versão estável: DLT é um serviço gerenciado com atualizações contínuas, em vez de versões estáveis distintas. Os recursos são implementados progressivamente.

- Data de Fim do Suporte: Não aplicável no sentido tradicional de software, pois trata-se de um serviço gerenciado. O suporte é contínuo enquanto a plataforma Databricks for suportada. O suporte para os recursos subjacentes do Delta Lake é rastreado por meio das versões LTS do Databricks Runtime.

- Data de fim de vida útil: Não aplicável.

- Data de expiração da atualização automática: Não aplicável, pois o DLT é um serviço gerenciado que recebe atualizações contínuas da Databricks.

- Tipo de licença: Proprietária, parte do modelo de licenciamento da plataforma Databricks, geralmente exigindo um plano Premium ou superior.

- Modelo de implantação: Serviço totalmente gerenciado baseado em nuvem. Ele é executado dentro do espaço de trabalho Databricks do usuário nos principais provedores de nuvem (AWS, Azure, Google Cloud).

Requisitos técnicos

O Databricks Delta Live Tables aproveita a infraestrutura escalável da plataforma Databricks Lakehouse. Os requisitos técnicos referem-se principalmente aos clusters Databricks subjacentes que executam os pipelines DLT.

- RAM: Configurável por nó do cluster, geralmente variando de 8 GB a centenas de GB, dependendo da complexidade da carga de trabalho e do volume de dados. A tecnologia DLT gerencia automaticamente o escalonamento computacional.

- Processador: Configurável por nó do cluster, utilizando diversas arquiteturas de CPU (por exemplo, Intel, AMD, ARM) oferecidas pelos provedores de nuvem. A tecnologia DLT otimiza o uso de recursos.

- Armazenamento: Utiliza armazenamento de objetos em nuvem (por exemplo, S3, ADLS Gen2, GCS) para persistência de dados (tabelas Delta Lake) e armazenamento temporário em nós do cluster. O armazenamento escala elasticamente com o volume de dados.

- Exibição: É necessário um navegador web moderno para acessar a interface do usuário do espaço de trabalho do Databricks para configuração, monitoramento e desenvolvimento de pipelines.

- Portas: HTTPS padrão (443) para acesso à interface web e à API. As portas de comunicação interna do cluster são gerenciadas pelo Databricks.

- Sistema Operacional: O Databricks Runtime, que é baseado em distribuições Linux otimizadas (por exemplo, Ubuntu, Photon OS), é executado nos nós do cluster.

Análise dos Requisitos Técnicos

A tecnologia DLT abstrai grande parte da gestão tradicional de infraestrutura. Os usuários definem suas transformações de dados e a DLT provisiona, dimensiona e gerencia automaticamente os recursos computacionais (RAM, CPU, armazenamento) necessários para executar os pipelines. Isso inclui a inicialização de novos clusters para execuções de atualização em modo de produção, garantindo um ambiente limpo e resolvendo problemas como vazamentos de memória. Os clusters Databricks subjacentes são altamente configuráveis, permitindo a otimização com base em necessidades específicas de carga de trabalho, desde pequenos ambientes de desenvolvimento até sistemas de produção de grande escala. A integração da DLT com o armazenamento de objetos em nuvem oferece armazenamento de dados praticamente ilimitado e econômico. O principal requisito técnico para o usuário é um navegador web compatível para interagir com a interface do Databricks. Essa abordagem gerenciada reduz significativamente a sobrecarga operacional para os engenheiros de dados.

Suporte e compatibilidade

O Databricks Delta Live Tables é parte integrante da plataforma Databricks Lakehouse, oferecendo suporte robusto e opções de compatibilidade.

- Última versão: O DLT é um serviço gerenciado com atualizações contínuas; novos recursos e melhorias são implementados regularmente, frequentemente em conjunto com as versões do Databricks Runtime.

- Suporte a sistemas operacionais: A DLT opera na plataforma Databricks, que funciona em infraestrutura de nuvem. Os usuários interagem por meio de navegadores da web, o que torna a compatibilidade com diversos sistemas operacionais do cliente bastante ampla.

- Data de Fim do Suporte: Como um serviço gerenciado, o DLT recebe suporte contínuo. O fim da vida útil de recursos específicos ou versões subjacentes do Databricks Runtime é comunicado pela Databricks.

- Localização: A interface de usuário do Databricks, por meio da qual os pipelines de DLT são gerenciados, oferece suporte a vários idiomas.

- Drivers disponíveis: Os pipelines DLT conectam-se a várias fontes e destinos de dados usando conectores integrados e o extenso ecossistema do Apache Spark. Isso inclui conectores para armazenamento de objetos em nuvem, barramentos de mensagens e diversos sistemas de banco de dados.

Análise do estado geral de suporte e compatibilidade

O DLT oferece forte compatibilidade e suporte devido à sua profunda integração com a plataforma Databricks Lakehouse e à sua utilização de padrões abertos como Delta Lake e Apache Spark. Ele suporta SQL e Python para definir a lógica do pipeline, proporcionando flexibilidade para engenheiros de dados. O DLT foi projetado para funcionar perfeitamente com outros recursos do Databricks, como o Unity Catalog para governança e o Auto Loader para ingestão eficiente de dados. O Databricks oferece documentação completa, fóruns da comunidade e suporte corporativo para sua plataforma, incluindo o DLT. A compatibilidade com diversas fontes e formatos de dados é ampla, aproveitando os recursos do Spark. Atualizações recentes aprimoraram a capacidade do DLT de publicar em múltiplos catálogos e esquemas, melhorando sua adequação a arquiteturas complexas de lakehouse.

Estado de segurança

O Databricks Delta Live Tables herda e amplia os recursos robustos de segurança da plataforma Databricks Lakehouse, projetada para governança e proteção de dados de nível empresarial.

- Recursos de segurança:

- Criptografia de dados em repouso e em trânsito.

- Mecanismos de controle de acesso (por exemplo, Catálogo do Unity, ACLs do espaço de trabalho).

- Controles de segurança de rede (ex.: link privado, listas de acesso IP).

- Expectativas de qualidade de dados para evitar dados incorretos.

- Monitoramento e auditoria automatizados.

- Suporte para chaves gerenciadas pelo cliente (CMK) para criptografia.

- A segurança em nível de linha (RLS) e o mascaramento de colunas são suportados para tabelas de streaming.

- Vulnerabilidades conhecidas: A Databricks mantém uma postura de segurança robusta, incluindo gerenciamento de vulnerabilidades e testes de penetração. Vulnerabilidades específicas da tecnologia de registro distribuído (DLT) são corrigidas por meio de atualizações contínuas.

- Status na lista negra: Não aplicável.

- Certificações: A Databricks adere a vários padrões e certificações de conformidade do setor, como SOC 2, ISO 27001 e HIPAA, que se aplicam ao serviço DLT.

- Suporte à criptografia:

- Criptografia TLS de ponta a ponta para dados em trânsito.

- Criptografia em repouso para dados armazenados em armazenamento de objetos na nuvem, com opções para chaves gerenciadas pela plataforma ou pelo cliente.

- A criptografia em nível de coluna pode ser implementada em pipelines de DLT (Distributed Ledger Technology).

- Métodos de autenticação: Integra-se com provedores de identidade corporativos (por exemplo, Azure Active Directory, Okta) para autenticação de usuários no espaço de trabalho do Databricks. Entidades de serviço podem ser usadas para a execução de pipelines.

- Recomendações gerais: Implemente o princípio do menor privilégio, configure listas de acesso IP, utilize o Unity Catalog para controle de acesso granular e monitore regularmente os registros de auditoria.

Análise da Classificação Geral de Segurança

O Databricks Delta Live Tables oferece um alto nível de segurança, aproveitando a estrutura de segurança abrangente da plataforma Databricks. Os dados são protegidos em múltiplas camadas, incluindo criptografia para dados em repouso e em trânsito, controles de acesso robustos e isolamento de rede. A integração com o Unity Catalog permite governança centralizada e permissões refinadas. Embora a própria tecnologia DLT seja segura por design, a implementação das melhores práticas para gerenciamento de acesso e classificação de dados no ambiente Databricks é crucial para manter uma postura de segurança robusta. Melhorias recentes, como RLS e mascaramento de colunas para tabelas de streaming, fortalecem ainda mais seus recursos de privacidade de dados.

Desempenho e indicadores de desempenho

O Databricks Delta Live Tables foi projetado para alto desempenho e eficiência na execução de pipelines de dados, especialmente para cargas de trabalho ETL.

- Resultados de benchmarks: A Databricks demonstrou a eficiência da DLT em benchmarks de ETL, mostrando que ela pode processar grandes volumes de dados (por exemplo, um bilhão de registros) de forma eficiente, muitas vezes superando fluxos de trabalho Spark ajustados manualmente.

- Métricas de desempenho no mundo real:

- O dimensionamento automático de recursos computacionais otimiza o desempenho para volumes de dados variáveis.

- Suporte para processamento de dados em lote e em fluxo contínuo dentro de uma estrutura unificada.

- Otimizações integradas para tabelas Delta Lake, incluindo agrupamento líquido.

- Gerenciamento eficiente de transformações incrementais de dados e Captura de Dados de Alteração (CDC).

- A redução dos custos operacionais leva a ciclos de desenvolvimento e implementação mais rápidos.

- Consumo de energia: Como um serviço nativo da nuvem, o consumo de energia é gerenciado pelo provedor de nuvem. O dimensionamento automático e a utilização otimizada de recursos da DLT contribuem para a eficiência energética, minimizando o tempo ocioso de computação.

- Pegada de carbono: O gerenciamento eficiente de recursos e as opções sem servidor do DLT contribuem para uma pegada de carbono reduzida em comparação com infraestruturas superdimensionadas e sempre ativas.

- Comparação com ativos semelhantes:

- Em comparação com as ferramentas ETL tradicionais: a DLT oferece uma abordagem declarativa, automatizando a orquestração, o escalonamento e a qualidade dos dados, o que simplifica o gerenciamento do pipeline em comparação com os sistemas ETL tradicionais orientados a lotes, como o Informatica ou o Talend.

- Em comparação com tarefas Spark codificadas manualmente: a tecnologia DLT abstrai grande parte da complexidade do gerenciamento de clusters e tarefas Spark, permitindo que os engenheiros de dados se concentrem em transformações em vez de infraestrutura. Frequentemente, ela alcança uma melhor utilização de recursos do que fluxos de trabalho manuais otimizados por especialistas.

Análise do Estado de Desempenho Geral

O Databricks Delta Live Tables oferece alto desempenho ao automatizar e otimizar aspectos essenciais da execução de pipelines de dados. Sua natureza declarativa, combinada com escalonamento automático inteligente e otimização contínua das tabelas Delta Lake subjacentes, garante o processamento eficiente tanto para cargas de trabalho em lote quanto para fluxos de dados contínuos. A capacidade do DLT de lidar com dados incrementais e CDC (Captura e Decodificação de Dados) de forma eficaz o torna adequado para análises em tempo real e armazenamento de dados. O foco da plataforma na redução da sobrecarga de gerenciamento de infraestrutura se traduz diretamente em ganhos de desempenho e eficiência de custos, já que os recursos são alocados e desalocados dinamicamente com base na demanda. Embora o DLT seja altamente otimizado, volumes de dados extremamente altos ou transformações complexas e altamente personalizadas ainda podem exigir um projeto de pipeline cuidadoso e configuração de recursos.

Avaliações e comentários dos usuários

As avaliações e comentários dos usuários sobre o Databricks Delta Live Tables geralmente destacam seus pontos fortes na simplificação da engenharia de dados, ao mesmo tempo que apontam algumas áreas para melhoria.

- Pontos fortes:

- Desenvolvimento simplificado de pipelines: os usuários apreciam a abordagem declarativa, que lhes permite focar no "o que" transformar em vez de "como", resultando em um desenvolvimento mais rápido.

- Automação: Orquestração automática, gerenciamento de clusters, monitoramento e tratamento de erros são benefícios frequentemente citados, reduzindo a carga operacional.

- Garantia da qualidade dos dados: as verificações de qualidade de dados integradas (expectativas) ajudam a garantir a integridade e a confiabilidade dos dados.

- Processamento Unificado em Lote e em Fluxo Contínuo: A capacidade de lidar com dados em lote e em fluxo contínuo dentro da mesma estrutura é uma vantagem significativa.

- Linhagem e Observabilidade: A DLT gera automaticamente gráficos de linhagem de dados, que são valiosos para entender dependências e depurar problemas.

- Suporte para CDC e SCD2: Simplifica a captura de dados de alteração e as implementações de Dimensão de Alteração Lenta Tipo 2.

- Pontos fracos:

- Experiência de desenvolvimento: Alguns usuários consideram que a experiência de desenvolvimento poderia ser melhorada, principalmente a impossibilidade de executar notebooks DLT diretamente e a necessidade de iniciar um fluxo de trabalho para gerar a saída.

- Limitações na personalização: A natureza declarativa do DLT significa menos controle preciso sobre cada configuração do Spark, o que pode ser uma desvantagem para usuários acostumados a trabalhos do Spark altamente personalizados.

- Mistura de linguagens: A impossibilidade de misturar SQL e Python no mesmo notebook DLT é uma limitação.

- Navegação entre esquemas e catálogos: Historicamente, a tecnologia DLT apresentava limitações na gravação em múltiplos catálogos ou esquemas dentro de um único pipeline, embora atualizações recentes tenham resolvido esse problema.

- Custo: Embora a tecnologia de registro distribuído (DLT) vise à eficiência de custos, alguns usuários expressam preocupação com o custo total em comparação com implementações manuais altamente otimizadas, embora as opções sem servidor estejam melhorando esse cenário.

- Depuração e monitoramento: Embora tenha havido melhorias, alguns usuários relataram dificuldades na análise detalhada do DAG gerado ou na depuração complexa.

- Casos de uso recomendados:

- Construindo pipelines ETL confiáveis e escaláveis.

- Processamento de transformações incrementais de dados e CDC.

- Implementação de arquiteturas multi-hop (Medallion) (camadas Bronze, Prata e Ouro).

- Otimização dos processos de ingestão de dados, especialmente com o Auto Loader.

- Garantir a qualidade e a integridade dos dados por meio de verificações automatizadas.

Resumo

O Databricks Delta Live Tables (DLT) é uma estrutura ETL declarativa e poderosa que simplifica significativamente o desenvolvimento e o gerenciamento de pipelines de dados na plataforma Databricks Lakehouse. Sua principal vantagem reside na automação de tarefas operacionais complexas, como gerenciamento de clusters, orquestração e tratamento de erros, permitindo que os engenheiros de dados se concentrem na definição de transformações de dados usando SQL ou Python. O DLT se destaca na garantia da qualidade dos dados por meio de expectativas integradas e oferece suporte robusto para cargas de trabalho em lote e em fluxo contínuo, incluindo implementações eficientes de Captura de Dados de Alteração (CDC) e Dimensão de Alteração Lenta (SCD) Tipo 2.

Os requisitos técnicos são abstraídos, uma vez que a DLT provisiona e dimensiona dinamicamente os clusters Databricks subjacentes, garantindo a utilização ideal dos recursos. Ela se integra perfeitamente ao ecossistema Databricks mais amplo, incluindo o Unity Catalog para governança, e aproveita o armazenamento de objetos em nuvem para persistência de dados escalável. A segurança é de nível empresarial, com criptografia abrangente, controles de acesso e certificações de conformidade herdadas da plataforma Databricks, aprimoradas ainda mais por adições recentes como Segurança em Nível de Linha e Mascaramento de Colunas para tabelas de streaming.

O desempenho é excelente, com o DLT frequentemente superando tarefas Spark otimizadas manualmente devido às suas otimizações automatizadas e à utilização eficiente de recursos. Ele oferece uma alternativa atraente às ferramentas ETL tradicionais, reduzindo a complexidade e acelerando os ciclos de desenvolvimento.

Embora a tecnologia DLT ofereça inúmeros benefícios, alguns usuários apontam limitações na experiência de desenvolvimento, principalmente a impossibilidade de executar notebooks DLT diretamente para obter feedback rápido. Historicamente, havia restrições quanto à gravação em múltiplos esquemas ou catálogos dentro de um único pipeline, além de um controle menos granular sobre certas configurações do Spark. No entanto, a Databricks busca constantemente solucionar esses problemas com atualizações contínuas, como recursos aprimorados de gravação em múltiplos catálogos e opções serverless para otimização de custos.

Em resumo, a tecnologia DLT é altamente recomendada para organizações que buscam construir pipelines de dados confiáveis, escaláveis e de fácil manutenção, com foco na qualidade dos dados e na eficiência operacional, especialmente em uma arquitetura Lakehouse. Ela é particularmente adequada para processamento incremental de dados, análise de fluxos de dados e implementação de arquiteturas Medallion. Embora exija uma mudança de mentalidade da programação imperativa para a declarativa e apresente algumas limitações específicas, seus benefícios em automação e simplificação a tornam um recurso valioso para a engenharia de dados moderna.

As informações fornecidas são baseadas em dados disponíveis publicamente e podem variar dependendo das configurações específicas do dispositivo. Para obter informações atualizadas, consulte os recursos oficiais do fabricante.